プレスリリース

ACUBE、AMDプラットフォームでのDeep Learning関連フレームワークを 用意したGPUサーバ・システム 「ACUBE DL・Machine LEARING BOX AMD EPYC-MI25x4」を発売

株式会社エーキューブは、AMD EPYC CPU、AMD Radeon INSTINCT MI25を採用、Deep Learning用フレームワーク「Caffe」、「TensorFlow」をインストールしたDeep Learning、HPC向けGPUサーバ・システム「ACUBE DL・Machine LEARING BOX AMD EPYC-MI25x4」を発表いたします。

このシステムは、AMD ROCm が提供する、HIPCaffe, ROCm-TensorFlow 1.3を活用して、AMDプラットフォーム下において、深層学習研究において高効率で高いパフォーマンスを発揮できるよう Caffe , TensorFlowのDeep learning関連フレームワークを整合性と動作確認がとれた状態でプレインストールしております。

このシステムは、AMD ROCm が提供する、HIPCaffe, ROCm-TensorFlow 1.3を活用して、AMDプラットフォーム下において、深層学習研究において高効率で高いパフォーマンスを発揮できるよう Caffe , TensorFlowのDeep learning関連フレームワークを整合性と動作確認がとれた状態でプレインストールしております。

ハードウエアとしては、コアパーツであるGPUは最大4基まで搭載可能で、大量の学習データに効率良くアクセスするためにCUDA , cuDNN , cuca-convnet などのNVIDIAソフトウェアスタッグやをSSD高速ストレージにプレインストールしました。AMD社 最新のAMD EPYCプロセッサファミリーを搭載した2Uラックマウント型のシングルソケットのHPCサーバーで、最大4台のアクセラレータに対応しています。これにより、従来の2ソケットシステムの性能と機能を損なうことなく、最高レベルのFP16コンピューティング性能を実現します。これにより、ミッションクリティカルなアプリケーションを高速化する、比類のないパフォーマンスを実現します。

また、DeepLearning用フレームワークである「Caffe」、「TensorFlow」がインストールされていますので、最適な環境でGPUサーバ・システムを活用することが可能です。

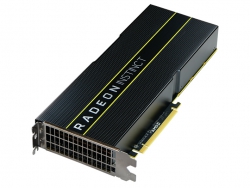

【Radeon™ INSTINCT MI25について】

Radeon INSTINCTのサーバーアクセラレータ製品ファミリーは、メタルインテリジェンスとHPCシステムの異機種混在コンピューティング機能の新時代をもたらします。次世代の「Vega」アーキテクチャや、ROCmソフトウェアプラットフォームを介したデータセンター設計へのRadeon INSTINCTのオープンエコシステムアプローチなどの世界クラスのGPUテクノロジの導入により、より高度なデータセンターのパフォーマンスと効率が実現し、様々なシステムアーキテクチャのサポートと業界標準的な相互接続技術をもたらします。

Radeon INSTINCTのサーバーアクセラレータ製品ファミリーは、メタルインテリジェンスとHPCシステムの異機種混在コンピューティング機能の新時代をもたらします。次世代の「Vega」アーキテクチャや、ROCmソフトウェアプラットフォームを介したデータセンター設計へのRadeon INSTINCTのオープンエコシステムアプローチなどの世界クラスのGPUテクノロジの導入により、より高度なデータセンターのパフォーマンスと効率が実現し、様々なシステムアーキテクチャのサポートと業界標準的な相互接続技術をもたらします。

Radeon INSTINCT製品ファミリーは、Deep LearningとHPCのデータセンターの新しい時代の構築ブロックとなるように設計されています。AMDは、Radeon INSTINCTのサーバアクセラレータ製品とソフトウェアプラットフォームを設計、最適化し、コスト効率の良いマシンと深い学習の推論、トレーニング、エッジトレーニングソリューションを提供しており、アクセラレータの高度な並列コンピューティング機能を最大限に活用できます。

Radeon INSTINCT製品は、学術、政府機関、エネルギー、ライフサイエンス、金融、自動車、その他の業界でデータ中心のHPCクラスのシステムにも理想的です。

14nmのFinFETプロセスを使用した次世代の「Vega」アーキテクチャに基づく受動的に冷却されたGPUサーバアクセラレータ

Radeon INSTINCT MI25サーバアクセラレータは、14nm FinFETプロセスを採用した新しい「Vega」アーキテクチャに基づいており、データセンターサーバの導入に最適化された演算密度向けに設計されたプロフェッショナルレベルのアクセラレータです。MI25サーバアクセラレータは、ワットあたりの性能が重要なマシンインテリジェンスやディープラーニングなどのHPCクラスのワークロードで、単精度の計算集中型トレーニングアプリケーションに最適なソリューションです。

300W TDPボードパワー、フルハイト、デュアルスロット、10.5 "PCIe®Gen 3 x16 GPUサーバーカード

Radeon INSTINCT MI25サーバーPCIe®Gen3 x16 GPUカードは、ほとんどの標準的なサーバーデザインに適合するように設計されたフルハイトのデュアルスロットカードで、異機種のマシンインテリジェンスやディープラーニングトレーニング、HPCクラスのシステム展開

最大484 GB / sのメモリ帯域幅を備えた超広帯域HBM2 ECCメモリ

Radeon INSTINCT MI25サーバアクセラレータは、最も要求の厳しいマシンインテリジェンスとディープラーニングニューラルネットワークトレーニングシステムのより大きなデータセット要件を効率的に処理するために、16GBの最新の高帯域幅HBM2メモリで設計されています。MI25アクセラレータの16GB ECC HBM2メモリは、データ集約型HPCクラスのワークロードに最適なソリューションです。

MxGPU SR-IOVハードウェア仮想化

Radeon INSTINCT MI25サーバアクセラレータは、AMDのMxGPU SRIOVハードウェア仮想化テクノロジをサポートするように設計されており、データセンターの利用率と容量を向上させます。

更新されたリモート管理機能

Radeon INSTINCT MI25アクセラレータは、大規模システムでのGPU監視を簡素化するために、帯域外の管理性回路を進化させました。MI25の管理機能に関係なく、GPUが基板部の詳細を、シリアル番号、GPU温度、電力および他の情報を含むPMCI準拠したデータ構造を使用して、静的および動的GPU情報の範囲の高度な監視を提供しているI2Cを介してアクセスの可能性を提供します。

【AMD EPYC シリーズについて】

世界中のIT組織では予算と容量の制約に直面しており、使用率の低いサーバーによって、この状況は悪化しています。現在、こういったデータセンターには、使用率向上と購買コスト削減を目的として設計された高性能の1ソケット・サーバーの選択肢がありません。AMD EPYCでは、TCOの大幅な縮小を約束、さらに、組織が機能を損なうことなくデータセンターの主要ワークロードに適したサイズを実現できます。

AMD EPYCは、最大32個のコア、8個のメモリー・チャネル、CPUあたり128レーンのPCIe® 3.0を搭載、かつては2ソケット・アーキテクチャーでのみ可能であった機能と性能をご利用いただけます。

【ROCmとは? 】

Radeon Open Compute Platform (ROCm)

ROCmは、Radeon Open Compute Platformの略で、AMD Radeon を使用したGPGPU向けのプラットフォームであり、以下の特徴を備えます。

・ 高パフォーマンス 低レイテンシ・高スループットに最適化された基盤

・ オープンソース プロフェッショナルGPGPUの完全なオープンソース

・ ハイパースケール ノードからラックまでのマルチアクセラータを構築

ROCmの最大の特徴はオープンであることです、ですので誰でも利用が可能です。

そして、ROCmを使用する事で、著名な Deep Learning 向けフレームワーク(Caffe, TensorFlow 等)をAMD基盤上で動作させる事が可能となります。

AMDによるGPGPU、Deep Leaning、Mining

AMD GPUを使用した GPGPU、Deep Learning、Mining では、特に使用条件や環境制限はありません。

AMD GPUはデータセンターでもどこでも、どんな目的でも簡単に即ご利用になれます。

| ACUBE DL・Machine LEARING BOX AMD EPYC-MI25x4 | |

| 製品名 | ACUBE DL・Machine LEARING BOX AMD EPYC-MI25x4 |

| 型番 | AC-INV-P47G4L10-EP7551Px1-128G-480SSD-MI254 |

| JANコード | 4537694259392 |

| GPU | AMD Radeon INSTINCT MI25 ×4 |

| フォームファクタ― | スライドレール付き2U1Nラックマウント |

| プロセッサー | シングルソケット; AMD® EPYC™ プロセッサーファミリー |

| メモリスロット | 16x DDR4 DIMMスロット |

| チップセット | SoC、128 PCIe Gen3レーン サポート |

| ストレージ コントローラー |

オンボード: 最大8つのSATA3(6Gbps)ポート 最大2つのU.2 NVMe サポート 最大2つのM.2 NVMe サポート |

| ネットワークコントローラー | 10GbE/25GbE/100GbE Mezz カードサポート |

| 拡張スロット | 4x PCIe Gen3 x16 standard slot for GPU (Double-wide, FHFL) 1x PCIe Gen3 x16 for 100G NIC/IB (FHHL) 1x OCP 2.0 A+B slot for 100G NIC/IB (Front access, Option) |

| ディスクドライブベイ | フロントプライマリベイ: オプション1: 8x 2.5” SATA3-6Gbs ホットプラグ HDD オプション2: 6x 2.5” SATA3-6Gbs ホットプラグ HDD + 2x NVMe SSD M.2 ソケット×2 サポート |

| システム管理 | IPMI 2.0準拠 |

| TPM | 2.0 |

| 電源 | 1 + 1冗長 オプション1: 1600W (220V) Platinum オプション2: 2000W (220V) Platinum |

| ファン | 5 + 1冗長性 6056ホットスワップファン |

| OS | Ubuntu 16.04.4 |

| Linux kernel | Upgraded to 4.13 |

| ROCm | 5月14日現在の最新バージョン(1.7.2、githubのマスターブランチ) |

| Docker | 18.05.0-ce |

| フレームワーク | HIPCaffe, ROCm-TensorFlow 1.3 |

| 保証期間 | 1年間 |

【発売開始時期】 2018年6月下旬予定

【販売価格】オープンプライス

【株式会社エーキューブ について】

米国AMD Inc.との協業により、Radeon™ Pro, FirePro™シリーズの販売及びマーケティング・サポート、技術サポートなどの事業活動を行っております。

〒102-0076 東京都千代田区五番町二番地カサ・ド・タク30C www.acube-corp.com

【AMDについて】

AMD(NYSE:AMD)は、コンピュータ業界、グラフィックス、家電業界向けに革新的なマイクロプロセッサ・ソリューションを提供するグローバル・プロバイダです。AMDは、世界中のコンシューマおよびビジネス分野のお客様を支援する、徹底したお客様中心主義の理念に基づくソリューションを提供します。それにより、オープンな技術革新の促進、選択肢の拡大、さらに業界の発展に向けて努力します。日本AMD株式会社は、AMDの日本法人です。詳細については、www.amd.com(英語)または http://www.amd.co.jp(日本語)をご覧ください。

<本件リリースに関するお問い合わせ先>

株式会社エーキューブ マーケティング担当: 田中 e-mail:このメールアドレスはスパムボットから保護されています。閲覧するにはJavaScriptを有効にする必要があります。

AMDは、Advanced Micro Devices, Inc.の商標です。AUBEは、株式会社エーキューブの商標です。その他すべての名称は、情報提供の目的においてのみ記載されているもので、名称を所有する企業・団体などの商標である場合があります。